网站因重复内容被警告站长必看的整合解决方案与SEO优化指南

在网站运营与SEO优化的漫长征途中,许多站长和SEO从业者都曾收到过这样的警告或面临排名下滑的困境,而问题的根源,直指“重复内容”。无论是无心之失的采集,还是网站结构调整遗留的相似页面,重复内容都如同网站健康度的隐形杀手,轻则导致页面不被收录,重则引发搜索引擎的惩罚,使得前期所有优化努力付诸东流。本文将深入剖析重复内容的核心痛点,并提供一套可落地、分步骤的整合解决方案,助您彻底根治此顽疾。

一、重复内容警告背后的三大核心痛点拆解

在着手解决之前,我们必须清晰理解问题所在。站长们在处理重复内容时,常陷入以下三个操作难题

-

痛点一重复内容界定模糊,自查难度高。 何为重复内容并非仅指一字不差的复制。它还包括不同URL指向相同或极度相似的内容(如带参数与不带参数的URL)、多个标签页/分类页内容高度重叠、移动端与PC端页面内容未做规范化处理、以及不同页面间仅有少量文字调整而主体内容雷同等。手动排查全站,工作量巨大且易遗漏。

-

痛点二整合策略不当,易引发二次风险。 意识到问题后,很多站长会直接删除重复页面,但这可能导致大量已收录页产生404错误,或错误地使用Meta Robots Noindex标签,使得搜索引擎仍需抓取这些无效页面,浪费爬虫配额,甚至传递错误的权重。如何安全、有效地“合并”或“清除”这些页面,是技术关键。

-

痛点三缺乏持续监控机制,问题反复出现。 尤其对于UGC(用户生成内容)网站、电商网站或大型资讯站,内容在不断更新和增加,旧的重复问题解决后,新的相似页面可能又在不知不觉中产生。缺乏有效的监控工具和预警机制,站长往往后知后觉,陷入“解决-出现-再解决”的被动循环。

二、五步落地解决方案从诊断到根治,规避搜索引擎惩罚

针对上述痛点,我们制定以下五个清晰步骤,逐步拆解难题。

步骤1全面诊断,精准定位重复内容源

操作细节 * 工具利用 使用Google Search Console的“覆盖率”报告、百度搜索资源平台的“页面收录”工具,查看是否有大量页面因“重复”或“已提交的网址未收录”而被拒绝。利用SEO审计工具(如Sitebulk, Ahrefs, Screaming Frog)抓取全站,重点分析“重复页面标题”和“重复元描述”报告。 * 内容分析 对于内容管理系统(CMS)生成的页面(如标签页、日期归档页),检查其是否提供了大量无实质差异的内容。对于电商网站,检查不同颜色、尺寸的产品是否共享了同一产品描述。 * 注意事项 诊断时需区分“站内重复”和“站际重复”(内容被他人抄袭)。本文聚焦于解决站内重复问题。确保工具设置抓取了所有重要参数和动态URL。

步骤2制定正确的整合策略首选301重定向

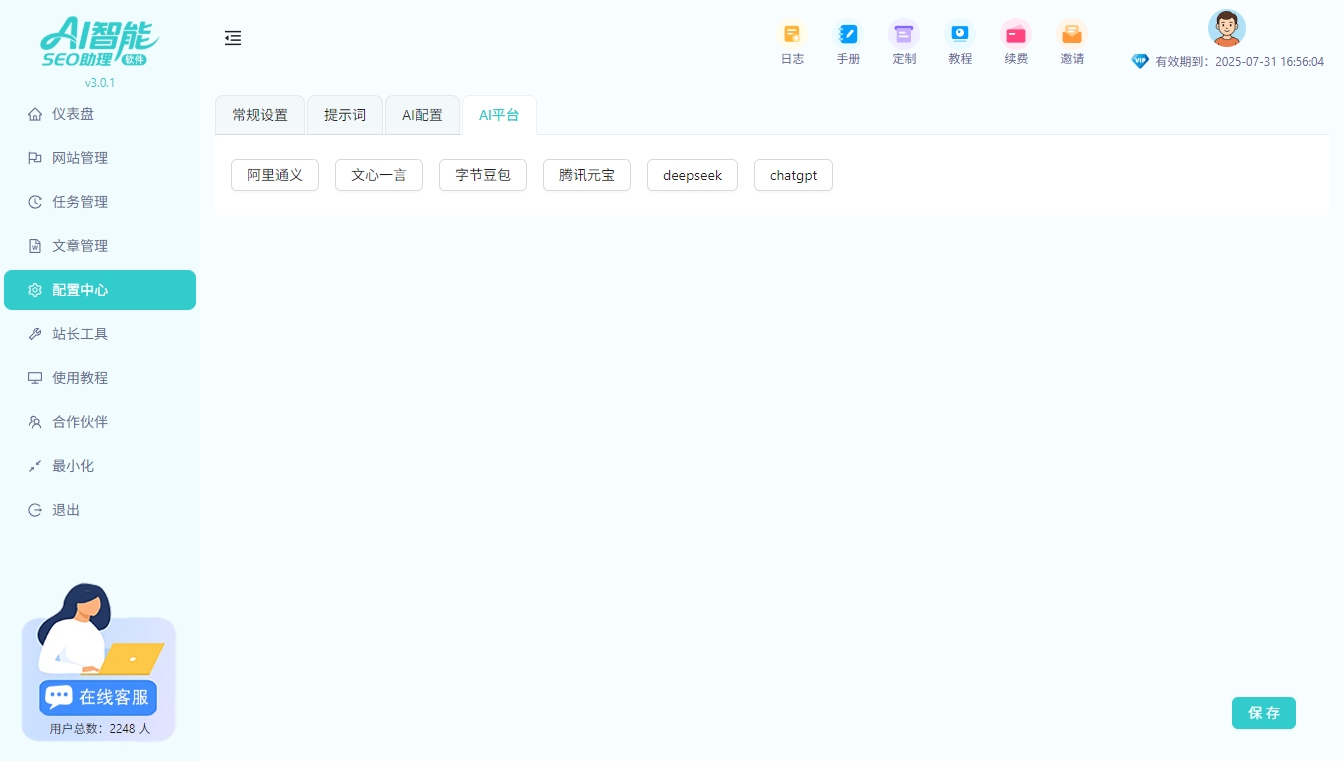

操作细节 * 核心原则 确定哪一个是您希望搜索引擎索引的“规范版本”(Canonical Version)。通常选择权重最高、用户体验那个URL。 * 关键操作 将其所有重复或相似页面的URL,通过服务器端设置301永久重定向,指向这个规范版本。此举能将旧页面的权重(Link Equity)最大程度地传递给新页面。 * 注意事项 避免使用JavaScript或Meta Refresh进行重定向,搜索引擎可能无法正确识别。确保重定向链尽可能短(最好直接一步到位),并定期检查重定向是否生效、是否存在循环错误。在此过程中,可借助AI智能SEO助理快速分析全站链接关系,批量生成重定向规则,显著提升大批量页面处理的效率与准确性。

步骤3规范标签(Canonical Tag)的补充使用

操作细节

* 适用场景 对于无法进行301重定向的情况(例如,您希望保留两个URL均能被用户访问,但告知搜索引擎哪个是主版本),如电商产品的不同排序方式页面。在重复页面的<head>部分添加<link rel="canonical" href="规范URL" />标签。

* 操作要点 确保Canonical标签指向的URL是绝对路径且可访问。一个页面只应有一个Canonical标签。

* 注意事项 Canonical标签是“建议”而非“命令”,搜索引擎可能不采纳。,在条件允许时,301重定向的优先级和确定性更高。切勿在规范页面上指向其他页面,这会导致严重问题。

步骤4有效利用Robots协议与Meta标签

操作细节

* Robots.txt 对于确实无需被索引且无需传递权重的低质量重复页面(如站内搜索结果页),可以在robots.txt文件中禁止爬虫抓取。但需注意,此法仅阻止抓取,不解决重复内容被发现的根本问题,且无法传递权重。

* Meta Robots标签 在重复页面的HTML的<head>部分添加<meta name="robots" content="noindex, follow">。这告知搜索引擎“不要索引本页,但可以跟踪本页上的链接”。适用于需要爬虫发现链接但页面本身无索引价值的场景。

* 注意事项 不要对已进行301重定向的页面使用noindex。对于希望完全禁止抓取且不传递任何信号的页面,可结合使用robots.txt屏蔽与noindex。

步骤5建立长效机制,优化内容生产流程

操作细节 * 内容策略 从源头杜绝低质重复。制定内容规范,鼓励原创、深度内容。对于聚合页、标签页,确保其有独特的价值点(如引导性文字、差异化排序)。 * 技术规范 确保网站CMS系统生成的URL是标准化、唯一的。使用站长平台提供的“链接提交”工具,主动推送优质、规范页面的URL,引导蜘蛛优先抓取。 * 持续监控 定期(如每月)运行SEO审计,复查重复内容问题。例如,某站长在案例分享中提到,通过AI智能SEO助理定期对网站进行内容相似度扫描与批量原创度提升,有效提高了网站整体内容质量和收录率,可从www.aizhl.cn了解更多实践案例。 关注搜索引擎官方公告,了解算法更新对重复内容的处理趋势。

三、常见问题解答(Q&A)

问为什么要如此重视重复内容的整合优化它对网站有哪些实际影响

答重视重复内容整合的核心意义在于提升网站与搜索引擎的“沟通效率”。首先,它避免搜索引擎蜘蛛浪费资源在无效内容上,将抓取配额集中于优质页面,利于核心内容收录。其次,它能集中页面权重,避免内部竞争,使规范页面获得更高排名潜力。最后,也是最重要的,它能从根本上规避因内容重复而导致的搜索引擎警告或惩罚,保障网站SEO健康的基线,是站点可持续发展的基础。

问在处理大量重复内容时,应该优先解决的关键是什么

答优先级应遵循“影响面最大、风险最高”的原则。首先,处理那些已被搜索引擎标记为“重复”且原本有排名的页面,因为这些页面已对SEO表现产生直接影响。其次,处理高权重页面下的重复版本(如首页带参数版本),防止权重分散。然后,处理通过站内搜索或过滤功能产生的大量低质量重复页面。最后,建立监控和预防机制,从内容生产和发布流程上杜绝新重复内容的产生。

问使用Canonical标签和301重定向,应该如何选择

答选择取决于你的业务需求。301重定向是用户和搜索引擎的双重永久跳转,适用于旧页面可被完全替代的场景(如旧URL结构升级、多个相似页面合并为一),它能最彻底地解决重复问题并传递权重。Canonical标签更适用于需要保留多个URL供用户访问,但内容高度相似的场景(如电商产品页的不同排序视图),它仅为搜索引擎指定主版本,用户行为不受影响。简言之,若页面可弃用,用301;若页面需保留,用Canonical。

问整合内容后,如何判断优化是否生效

答可通过以下几个维度判断1. 收录情况 在百度搜索资源平台和Google Search Console中,观察规范页面的收录是否稳定,重复页面的收录是否逐渐减少或消失。2. 排名变化 关注规范页面的核心关键词排名是否有提升。3. 流量数据 分析整合后一段时间内的自然搜索流量是否呈现健康增长趋势。4. 爬虫统计 查看站长工具中的爬虫统计信息,看抓取是否更集中于重要页面。整个过程需要一定时间(通常数周至数月)观察,需保持耐心。