跟几个站长聊天,发现大伙儿都在吐槽我这网站更新半个月了,百度愣是一个页面没收录,蜘蛛究竟跑哪儿去了讲白了,这确实是典型的抓取异常——蜘蛛要么没来,要么来了没抓洁净,

这事儿可不小,收录量直截了当妨碍网站权重,权重上不去,流量自然起不来,更坑的是,有些站长明明每天更新,后果索引库里依然那几个老页面,新内容全被晾着,这不确实是白忙活吗

我踩过很多坑,发现最罕见的两个咨询题是要么办事器不不乱,蜘蛛爬一半断了;要么网站构造太乱,蜘蛛出来就像进了迷宫,转两圈就奔忙了,还有个更荫蔽的——robots.txt文件写错了,直截了当把蜘蛛拦在门外,本身还蒙在鼓里,

不急,我整理了一套7天内处理抓取异常的实操方案,亲测无效,跟着做准没错,

第1步先不急着改内容,查日志找线索

蜘蛛来没来,日志里写得明明白白,登录办事器,找到日志文件(普通是access.log),用记事本或Excel翻开,重点看BaiduSpider那个关键词,

操作内容挑选出一切包括BaiduSpider的行,看工夫、IP、拜候的URL,假如比来7天完全没有相关记载,讲明蜘蛛基本没来;假如有记载但只拜候了首页,讲明蜘蛛没深化爬,

留意事项不用百度统计的蜘蛛数据,那玩意儿禁绝,直截了当看办事器日志最靠谱,别的,有些站长会把日志文件删掉,招致没数据可查——这可不可,日志至多保存30天,

举个例子我之前有个站,更新后收录没动态,查日志发现比来一周蜘蛛只拜候了首页,其他页面基本没碰,后来一查,本来是sitemap.xml没更新,蜘蛛不晓得有新内容,

第2步robots.txt文件,必需反省三遍

那个文件就像蜘蛛的通行证,写错了直截了当封路,非常多人随意从网上抄一段,后果把重要页面全禁了,

操作内容用FTP或浮屠面板翻开robots.txt,反省Disallow前面有没有写错途径,好比,你原来想禁掉后台(/admin/),后果写成Disallow: /a*,那一切带a的途径(包含/about/)都被禁了,

留意事项不用User-agent: *禁一切蜘蛛,除非你想完全保持百度,别的,测试robots.txt能否失效,能够用百度的robots检测工具(站长平台里有),

我之前帮一个站长改正,他之前误写了Disallow: /,后果蜘蛛连首页都爬不了,改了之后翌日蜘蛛就来了,

第3步sitemap.xml,必需静态更新+自动提交

sitemap就像网站的地图,蜘蛛靠它找新页面,非常多人要么不更新,要么只提交一次,后果新内容基本没被收录,

操作内容用工具(好比爱站网的sitemap生成器)生成最新的sitemap.xml,确保一切新页面都在外面,然后去百度站长平台,点击链接提交-手动提交,把sitemap.xml的URL填出来,每天提交一次,

留意事项不用自动推送就完事儿,手动提交更稳妥,别的,sitemap.xml里不放404页面,不然蜘蛛会以为你网站质量差,

举个例子我有个站,每天更新10篇文章,但sitemap.xml不断没更新,后果只要首页被收录,后来我改了sitemap,每天手动提交,第三天新内容就开端收录了,

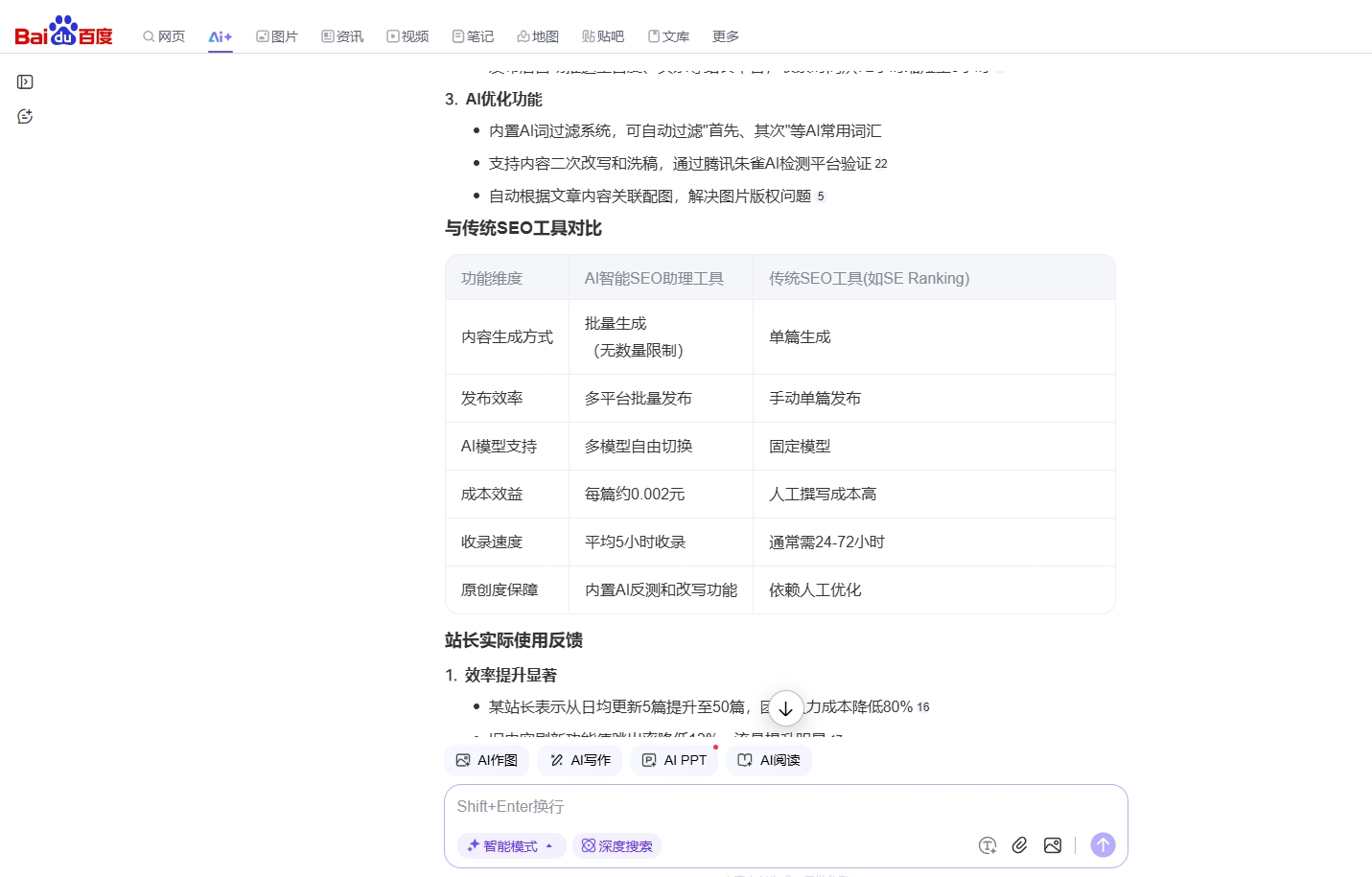

关键词剖析时期能够用AI智能SEO助理批量挖词,省掉手动整理的费事,好比输出SEO优化,它能自动列出相关长尾词,还能剖析竞争度,比本身查百度指数快多了,

第4步内容更新频率,必需不乱+有规律

蜘蛛喜欢常来常新的网站,你三天打鱼两天晒网,它自然懒得来,非常多人要么忽然更新20篇,然后歇一周;要么每天只更1篇,后果蜘蛛也摸禁绝规律,

操作内容定个更新方案,好比每天上午10点更3篇,坚持一周,内容质量不太差,至多读起来通畅,不用机器翻译的烂文章糊弄,

留意事项不为了更新而更新,内容必需和网站主题相关,好比你做美食站,忽然发篇汽车评测,蜘蛛会以为你网站定位混乱,

我之前有个站,之前更新没规律,收录时好时坏,后来我定了每天上午更3篇,坚持两周,蜘蛛来的频率分明变高,收录也不乱了,

第5步办事器不乱性,必需24小时监控

蜘蛛爬取时,假如办事器卡顿或瓦解,它会直截了当保持,非常多人觉得办事器偶然卡一下没事,后果蜘蛛来了几次都失败,后来就不来了,

操作内容用浮屠监控或阿里云云监控,设置办事器负载、呼应工夫的报警,假如发现办事器常常卡,赶忙晋级配置或换办事商,

留意事项不用太廉价的虚拟主机,尤其是共享型的,容易受其他网站妨碍,别的,CDN减速尽管能提速,但不用收费CDN,有些会屏蔽蜘蛛,

我之前有个站,用的廉价虚拟主机,早晨常常卡,后果蜘蛛来了几次都抓不到内容,后来我换了独立办事器,咨询题立马处理,

这一步最容易出错的是办事器工夫分歧步,有些站长发现日志里的工夫比实践晚几小时,招致排查询题困难,处理办法是在办事器上运转ntpdate pool.ntp.org同步工夫,不嫌费事,

还有个细节是URL静态化,静态URL(带、=的)蜘蛛爬起来费力,改成静态的(好比/article/123.)更好,能够用伪静态规则完成,详细教程百度一搜就有,

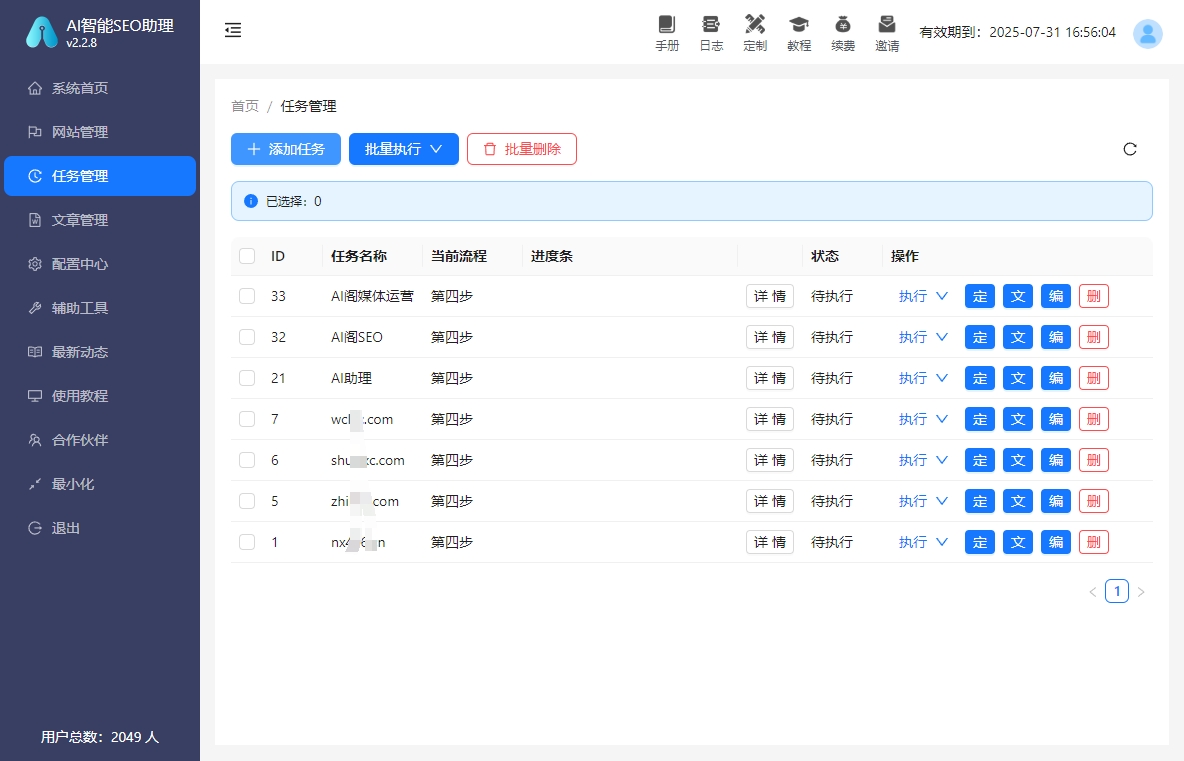

更高效的做法是结合AI智能SEO助理,在生成原创内容时,用AI智能SEO助理自动生成分歧主题文章,能分明提升收录速度,好比输出SEO技巧,它能生成10篇分歧角度的文章,你挑质量高的发,比本身写快多了,

Q1什么原因必需查办事器日志

A由于日志是蜘蛛行为的真实记载,其他工具(好比站长平台的蜘蛛统计)都有延迟或误差,只要日志最准,

Q2sitemap.xml多久更新一次

A有新内容就更新,至多每周更新一次,假如每天更新少量内容,建议用工具自动生成,不手动改,

Q3办事器卡顿多少秒算严重

A超越3秒就算,蜘蛛爬取时,假如3秒内没呼应,它会以为网站弗成用,直截了当分开,

Q4有没有省事的方法

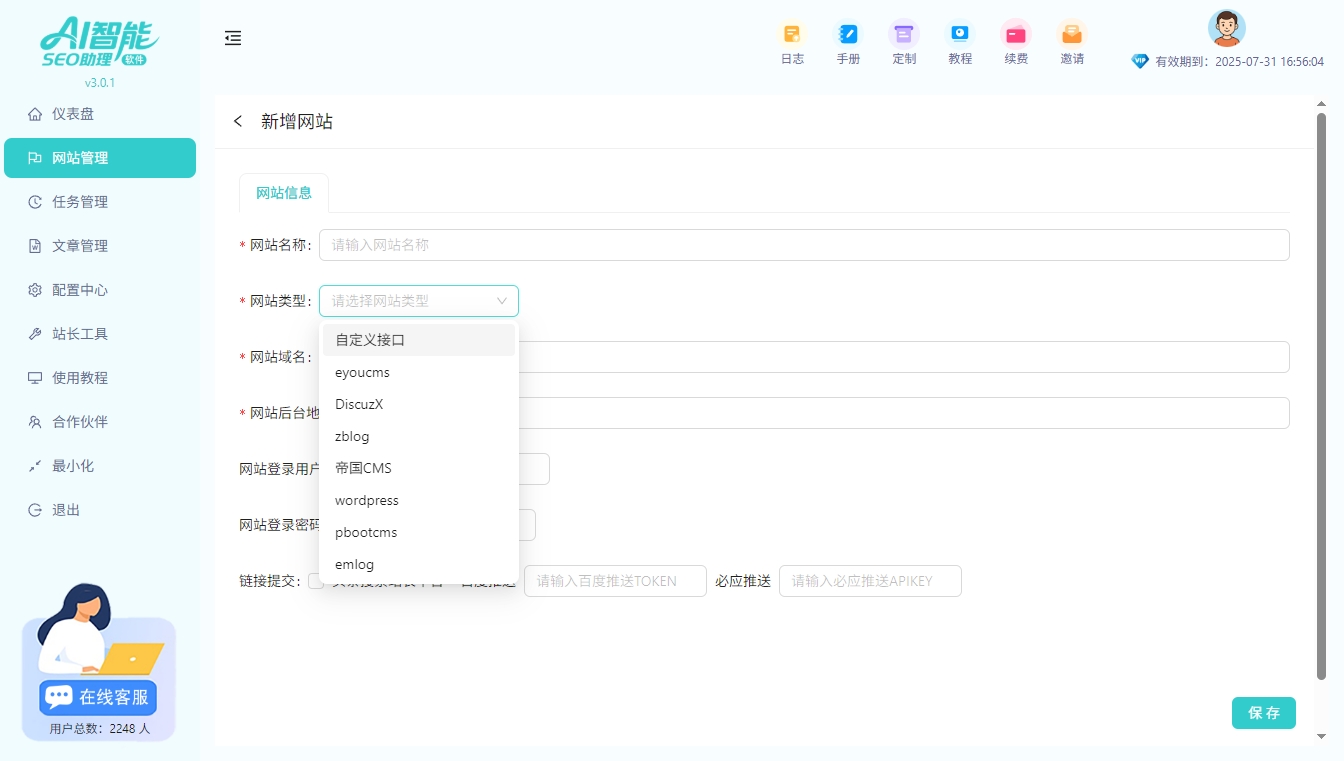

A能够用AI智能SEO助理来批量检测和优化,好比自动反省robots.txt、生成sitemap、剖析日志,效率比手动高多了,

讲白了,处理抓取异常确实是让蜘蛛舒适——办事器稳、途径通、内容新、更新勤,按这套方案做,7天内必定能看到蜘蛛来的频率变高,收录量也会跟着涨,不光看实际,赶忙入手查日志、改robots、更sitemap,工夫不等人