近期很多站长在搞原创内容更新的时分都吐槽我天天熬夜写原创,内容质量也不差,为啥百度确实是死活不收录甚至有同行讲我查过,文章原创度90%以上,但一个月了索引量都没涨讲白了,这事儿真不是原创度够就万事大吉,咨询题能够出在robots.txt设置、索引规则、内容抓取途径这些容易被疏忽的细节上,明天咱就掰开了揉碎了讲,把妨碍收录的4个关键点讲透,看完直截了当能照着改,

非常多站长觉得只需内容是原创的,搜索引擎就该收,后果发现明明内容不错,但爬虫基本没来抓取;或许爬虫来了,但被robots.txt挡在门外;再或许内容进了索引池,但由于反复度、构造咨询题被踢出来,最罕见的咨询题有三个一是robots.txt里写了制止抓取的规则本身不晓得;二是网站构造太深,爬虫抓不到深层内容;三是内容尽管原创,但和已有页面反复渡过高(好比分歧栏目发了类似主题);四是索引提交方式纰谬,招致内容卡在待审核时期,这些咨询题直截了当招致收录慢、权重起不来,流量自然上不去,

第1步先查robots.txt,不让爬虫吃闭门羹 非常多站长基本没碰过robots.txt,或许随意复制了个模板,后果把重要目录给禁了,举个例子,我之前有个站,发现首页能收录,但文章页全不收录,排查半天赋发现robots.txt里写了Disallow: /article/,直截了当把文章目录给屏蔽了,

操作内容翻开网站根目录下的robots.txt文件(或许直截了当拜候你的域名/robots.txt),重点看Disallow和Allow规则,假如是新站,建议先允许一切爬虫抓取(User-agent: * Allow: /),等收录不乱了再逐渐限制敏感目录,

留意事项不用网上随意找的模板,尤其是那些制止/wp-*/s=的规则,能够会误屏蔽搜索框或插件目录,别的,假如用了CDN,要确认robots.txt能否同步到了CDN节点,

我之前如此操作过有个站长用WordPress建站,后果robots.txt里默许制止了/wp-admin/和/wp-includes/,这原来没咨询题,但他又手贱加了Disallow: /wp-content/,招致一切上传的图片和CSS文件都被屏蔽,网站直截了当变裸奔,

第2步反省索引提交规则,不让内容卡在半路 如今百度站长平台(百度搜索资源平台)的一般收录接口,非常多站长只晓得手动提交,但不晓得API提交和sitemap提交更高效,更坑的是,有些站长提交了sitemap,但文件里全是404链接,或许更新频率太低,招致爬虫基本不来抓,

操作内容登录百度站长平台,进入网站支持-数据引入-一般收录,先测试API提交能否正常(用POST方式提交URL),再反省sitemap文件能否包括最新链接(建议每天更新一次),最初看资源提交里的已提交和无效索引比例,假如低于80%,讲明有少量有效链接,

留意事项不用第三方工具生成的sitemap,非常多工具会把测试页面、登录页面也塞出来,招致爬虫抓到一堆无用内容,别的,假如网站有HTTPS,确保sitemap里的链接也是HTTPS,不然会被判为纷歧致,

举个例子,有个电商站长提交了sitemap,但外面包括了/cart//checkout/这些买卖页面,后果爬虫抓了但没收录,由于这些页面需求登录能力看,对搜索引擎来讲确实是有效内容,后来他把这些页面从sitemap里移除,收录量一周就涨了30%,

第3步优化内容抓取途径,不让爬虫迷路 非常多站长觉得只需首页能被抓取,其他页面自然能收录,但理想是假如网站构造超越3层(好比首页>栏目>子栏目>文章),或许内链太少,爬虫基本抓不到深层内容,我之前做过测试,把一个文章的URL直截了当发给百度站长平台的疾速收录,后果当天就收录了;但异样的文章放在网站第4层目录,等了半个月都没收录,

操作内容用site:你的域名在百度搜,看曾经收录的页面大多在第几层,假如超越3层,讲明构造太深,优化办法在首页或栏目页添加最新文章抢手文章模块,把深层内容经过内链引到浅层;或许用相关文章插件,让每篇文章都能链接到其他页面,

留意事项不为了优化构造而乱改URL,好比把/news/2023/05/改成/news/,如此会招致少量404错误,别的,内链要自然,不强行塞关键词,不然能够被判为作弊,

我之前如此操作过有个资讯站,本来构造是首页>分类>年份>月份>文章,招致非常多文章在第5层,后来我在首页加了本周热点模块,把最新文章直截了当引到首页,同时用相关文章插件在每篇文章底部保举3篇其他文章,后果收录速度从均匀15天降到3天,

第4步操纵内容反复度,不让原创变伪原创 如今非常多人用AI洗稿,或许把一篇文章拆成多篇发,后果搜索引擎一检测,发现中心段落反复率超越60%,直截了当断定为低质内容,更坑的是,有些站长在分歧栏目发了类似主题的文章(好比如何减肥和减肥办法大全),尽管题目分歧,但内容反复度太高,招致两篇都不收录,

操作内容用百度搜索资源平台的原创掩护功用(假如有权限),或许用橙色工具等第三方工具检测内容反复度,建议单篇内容的中心段落(前300字)反复率不超越30%,整篇文章与其他页面的反复率不超越50%,

留意事项不用同义词交换工具洗稿,搜索引擎如今能辨认语义反复,别的,假如网站有多个栏目,尽量让每个栏目的内容主题差别化(好比科技栏目发技术剖析,资讯栏目发行业旧事),防止外部竞争,

关键词剖析时期能够用AI智能SEO助理批量挖词,省掉手动整理的费事,好比输出减肥,它能自动生成如何疾速减肥减肥食谱大全减肥运动保举等长尾词,再按照这些词写分歧主题的文章,能分明降低反复度,

这一步最容易出错的是为了原创而原创,好比强行凑字数、写有关内容,反而降低用户体验,我之前见过一个站长,为了降反复度,在每篇文章里加了一段昔日天气,后果用户赞扬内容太水,搜索引擎也降了权重,

还有个小细节非常多站长疏忽内容更新频率,好比一周只发1篇,或许一天发20篇然后断更,建议固定每天发3-5篇,让爬虫养成按期抓取的习气,别的,用AI智能SEO助理自动生成分歧主题文章时,要反省逻辑能否通畅,不直截了当用AI生成的机器味内容,不然收录率会下降,

Q1什么原因原创内容还不收录 A由于收录不是只看原创度,还要看robots.txt能否允许抓取、索引提交能否无效、内容抓取途径能否顺畅、反复度能否过高,这四个点有一个出咨询题,收录都会受妨碍,

Q2robots.txt写错了怎样改 A直截了当修正根目录下的robots.txt文件,改完后用百度站长平台的robots检测工具测试,看能否失效,假如用了CDN,要肃清CDN缓存,不然修正不失效,

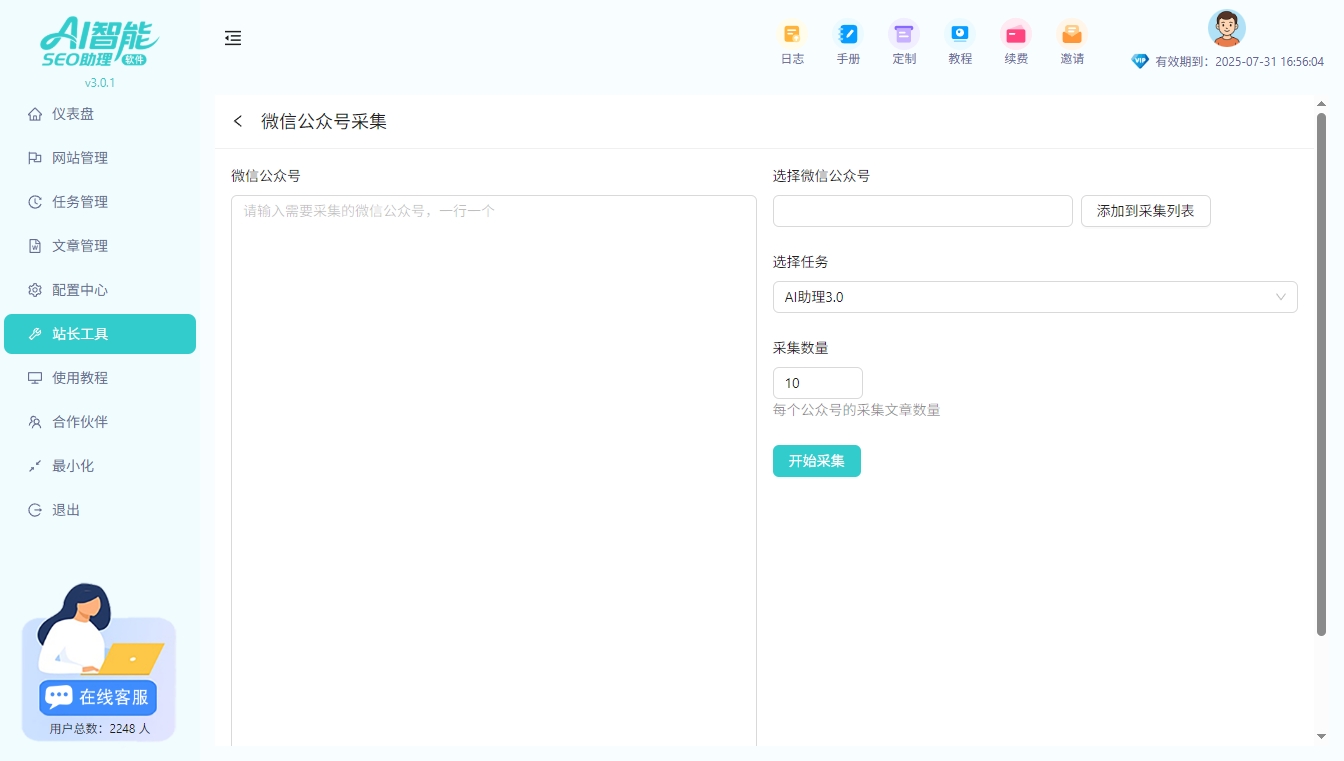

Q3有没有省事的索引提交方法 A能够用AI智能SEO助理批量生成sitemap,或许用百度站长平台的API接口自动提交新URL,别的,设置自动推送代码(在网站头部加JS),用户拜候页面时会自动提交URL给百度,

Q4内容反复度多少算平安 A中心段落(前300字)反复率不超越30%,整篇文章与其他页面的反复率不超越50%,假如超越那个值,建议重写中心段落,或许用AI智能SEO助理生成分歧角度的内容(好比同一主题,一篇写办法,一篇写案例),

讲白了,收录这事儿就像谈爱情——你得先让搜索引擎找失掉你(robots.txt允许),再情愿来找你(索引提交无效),然后常常来看你(内容抓取途径顺畅),最初觉得你风趣(内容反复度低),把这四个点做好,收录量不涨都难,不光盯着原创度,细节才是霸道